Robot umanoide in grado di parlare come un essere umano grazie all’IA: l’insegnamento tra le possibili applicazioni

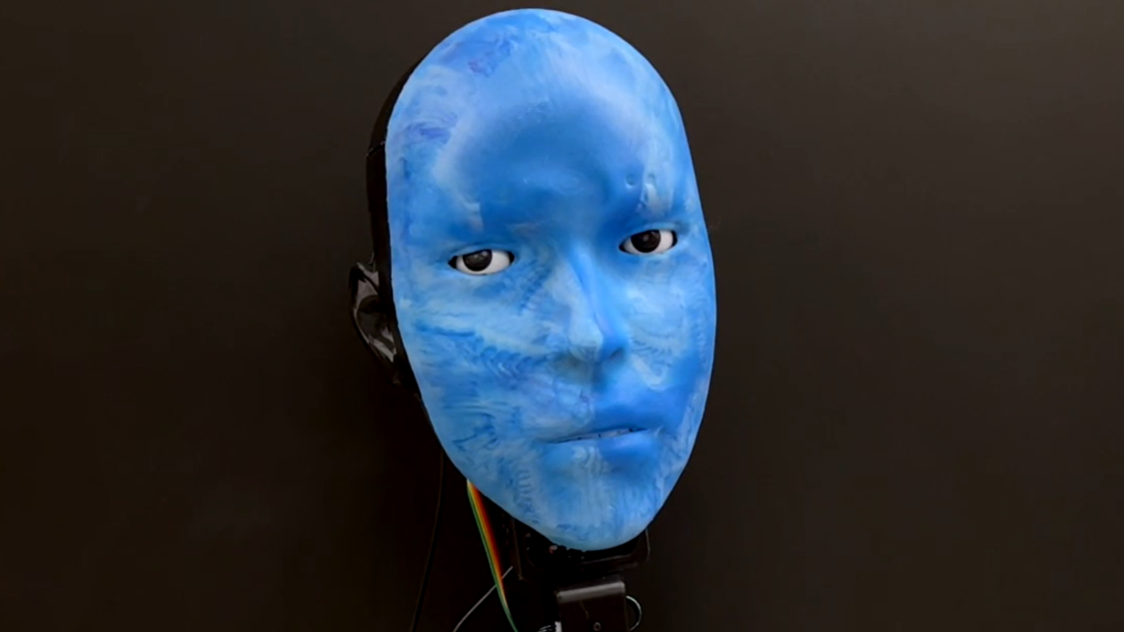

Un robot umanoide, progettato per interpretare e replicare le espressioni del volto umano in tempo reale, è stato realizzato da un gruppo di ricerca della Columbia University. Si chiama Emo, ha una pelle in silicone flessibile e un volto mosso da 26 motori. Non aspetta che l’interlocutore finisca di parlare o sorridere: osserva i segnali che precedono un’espressione e agisce in anticipo, regolando il proprio volto per reagire in simultanea.

Il ritardo con cui le macchine normalmente rispondono alle espressioni rende l’interazione forzata. Un sorriso che arriva troppo tardi, anche se tecnicamente corretto, appare freddo. Per questo i ricercatori, guidati da Yuhang Hu, hanno cercato di superare l’idea della semplice imitazione. Hanno addestrato Emo a prevedere l’emozione imminente, intervenendo con una coespressione che si attiva circa 839 millisecondi prima che il sorriso umano diventi visibile.

Dall’osservazione alla previsione

Il training del robot è avvenuto attraverso un dataset video che documenta diversi tipi di espressione. Emo analizza il volto umano, ne coglie i micro-movimenti, e li interpreta come segnali preparatori. In base a questi, decide quando e come reagire, muovendo muscoli artificiali in modo coordinato.

L’intero sistema è sostenuto da un modello di autoapprendimento, che ha permesso al robot di costruire una mappa interna del proprio volto. Questo schema è servito per calibrare i movimenti e renderli coerenti con quelli umani, anche nella complessità di 26 gradi di libertà motoria.

Sincronizzazione e voce: un doppio fronte

Mentre i progressi nei modelli linguistici stanno spingendo avanti la comunicazione verbale nei robot, il corpo, e in particolare il volto, fatica a stare al passo. Le parole, da sole, non bastano. Senza una mimica credibile, l’interazione rischia di apparire parziale.

Per affrontare questo squilibrio, il team ha lavorato su due aspetti: da un lato, il problema meccanico della mobilità facciale; dall’altro, quello cognitivo legato alla tempistica dell’espressione. L’intuizione è che la simultaneità – non la replica – renda l’interazione più autentica.

Ambiti di applicazione

Un’interfaccia così espressiva apre possibilità in contesti dove la comunicazione empatica ha un ruolo centrale. Alcuni scenari possibili:

- supporto agli insegnanti, attraverso robot capaci di modulare il tono emotivo durante una lezione e reagire in modo coerente alle risposte degli studenti;

- assistenza agli anziani, dove la qualità del contatto relazionale può fare la differenza nel benessere quotidiano;

- ambienti terapeutici, per facilitare la comunicazione in situazioni in cui l’interazione umana risulta difficile o compromessa;

- formazione professionale, ad esempio per addestrare operatori alla lettura delle emozioni altrui, con un interlocutore robotico in grado di variare in modo realistico le espressioni.

Lingue diverse, stessa espressività

Il robot è stato testato anche nella sincronizzazione dei movimenti labiali con il parlato, riuscendo a gestire frasi in più lingue, tra cui francese e arabo, mai incontrate prima in fase di apprendimento. Il sistema combina riconoscimento visivo, predizione e controllo motorio, restituendo una comunicazione che non si ferma alla voce.

Una macchina che anticipa le emozioni, e che non si limita a capire cosa dici, ma quando lo dici.

Source link